2025年10月27日,多媒体领域的全球顶级学术盛会——第33届ACM国际多媒体会议(ACM MM 2025) 在爱尔兰都柏林的皇家都柏林会议中心正式拉开帷幕。作为中国计算机学会(CCF)认证的A类旗舰会议,本届会议以 "跨模态信息的整合和交换" 为主题,将在未来五天里,汇聚来自多个国家的顶尖学者与产业专家,共同探索多模态人工智能、生成式内容、多媒体内容理解等前沿方向。实验室的博士生董彪、硕士生周永扬同学参与了本次会议,并做论文汇报。

董彪报告论文Talking Head Generation via Viewpoint and Lighting Simulation Based on Global Representation。当前基于NeRF的虚拟数字人头像生成在高质量细节保真度方面存在不足,主要表现为细节丢失和间歇性模糊。为了解决这些问题,论文提出了一种新颖的Talking Head生成方法,该方法结合了分层视点模拟(LVS)和连续光照模拟(CLS)两个有效策略。LVS通过视频帧的多尺度特征模拟多视点,以构建全局深度表征,从而提高体积密度估计的精度并增强细节描述。CLS通过连续视频帧的亮度变化模拟多光照,以构建全局亮度表征,从而减轻颜色累积误差并消除模糊。大量实验表明,与最先进的方法相比,该方法显著提高了细节质量。

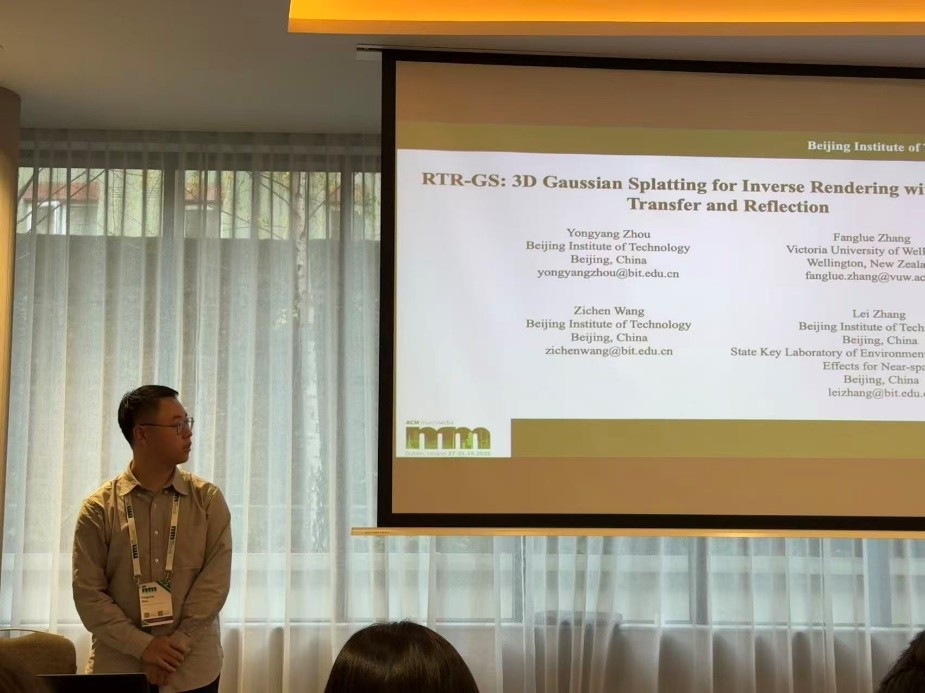

实验室的周永扬同学参与了本次会议,并做论文汇报。周永扬报告论文RTR-GS: 3D Gaussian Splatting for Inverse Rendering with Radiance Transfer and Reflection(基于辐射传输和反射的3D高斯泼溅逆渲染方法)。当前基于3D高斯的三维重建以及逆渲染任务中,球谐函数难以表示高频外观变化,容易造成几何破损,使得后续的外观分解难以进行。该论文首先提出了一种结合神经辐射传输和反射的混合渲染方法,能够有效恢复不同频率的外观变化。在此基础上提出了一种双分支渲染框架,能够有效实现物体的外观分解。实验证明,该方法能够有效重建各类物体几何并准确的将外观分解外材质和光照,并支持重光照、材质编辑等下游任务。